Usted está aquí

Arte y Tecnología

Composición y performance audiovisual con Medios Digitales.

Autor

Fernando Enrique Franco Lizarazo

Profesor Universidad de los Andes y Pontificia Universidad Javeriana

Resumen

Desde finales del siglo XX se han desarrollado una gran variedad de sistemas audiovisuales con medios digitales haciendo énfasis en la flexibilidad y expresividad, con base en aspectos como el control gestual, la representación visual dinámica (video, animación), el procesamiento de imagen, la síntesis y el procesamiento de sonido, las tecnologías de comunicación y la configuración o mapeo (mapping) flexible. El autor de este artículo ha desarrollado varios proyectos en contextos académicos y de creación artística, que servirán como referencia para explicar algunos de los conceptos propuestos.

Una posibilidad interesante relacionada con los sistemas audiovisuales es combinar las actividades de composición e interpretación. La flexibilidad de un sistema para reconfigurar las relaciones entre imagen y sonido y la posibilidad de controlarlos a varios niveles, son aspectos fundamentales para apoyar la creatividad y la realización de composiciones audiovisuales.

Introducción

Un aspecto interesante de varios sistemas audiovisuales para composición y performance basados en medios digitales, es el uso de imagen en movimiento como representación del sonido. De esta forma hay dos dimensiones estrechamente relacionadas en estos sistemas: espacio y tiempo. Algunos de estos sistemas, conocidos como Painterly Interfaces (Levin, 2000), aprovechan la temporalidad y espacialidad implícita en el trazo (dibujo, pintura) para añadir expresividad a las salidas visuales y sonoras. Otros sistemas que ofrecen dinamismo visual están basados en objetos visuales predefinidos que pueden ser modificados y animados. De esta manera la interactividad, control y expresión, juegan un papel muy importante y se han aplicado de varias formas en sistemas como FMOL desarrollado por Sergi Jordá (Jordá, 2003) y Loom, Aurora, Floo, Warbo and Yellowtail desarrollados por Golan Levin (Levin, 2000).

Aunque exista una retroalimentación entre imagen y sonido, la pregunta radica en cuál es la mejor forma de especificar sus características y hacerlas expresivas. El gesto es una fuente obvia y muy importante para la expresividad en el comportamiento humano. Las características temporales y espaciales de los gestos capturados mediante un dispositivo de entrada (sensores, controladores), pueden usarse para controlar diversos parámetros visuales y sonoros. En cuanto a la estructura de estos sistemas, ha sido útil el planteamiento de módulos de generación de sonido e imagen y módulos de control que se interconectan de diversas formas, permitiendo flexibilidad en su configuración de acuerdo a las necesidades de la obra y del artista.

A partir de la experimentación y revisión de diversos sistemas audiovisuales se han encontrado algunas características recurrentes que facilitan la flexibilidad y expresividad como son: manipulación de instrumentos u objetos como estrategia de interacción, adaptabilidad a diferentes niveles de habilidad, uso del sonido e imagen como canales de comunicación al mismo nivel, captura de gestos naturales de los seres humanos, control de parámetros discretos y continuos, incorporación de varios grados de libertad y retroalimentación visual, sonora y háptica. A continuación se explican los aspectos mencionados y como se han aplicado en varias obras audiovisuales.

Control gestual

El significado de gesto puede variar significativamente dependiendo del contexto. Sin embargo, la diversa naturaleza del gesto en la interacción hombre-computador, música y artes escénicas, presenta conceptos útiles para este artículo. De manera general, las acciones de un intérprete se pueden clasificar así: acciones donde no hay contacto físico con un instrumento o dispositivo y acciones donde existe alguna clase de contacto físico o manipulación de un objeto (Wanderley, 2001; Mulder, 1998).

Cadoz (1988) propone tipologías de gesto instrumental para generar sonido de la siguiente manera:

a) Gestos de excitación que pueden ser instantáneos (el sonido empieza cuando el gesto termina) o continuos (cuando el gesto y el sonido coexisten).

b) Gestos que modifican las propiedades del instrumento.

c) Gestos de selección que pueden ser secuenciales o paralelos. En el con texto de la interacción multimodal en un ambiente virtual, Choi (1998) propone una clasificación de movimientos humanos fundamentales que relacionan al sujeto con las respuestas dinámicas en un ambiente, en tres tipos: basados en trayectorias, basados en la fuerza (grados de movimiento) y basados en patrones.

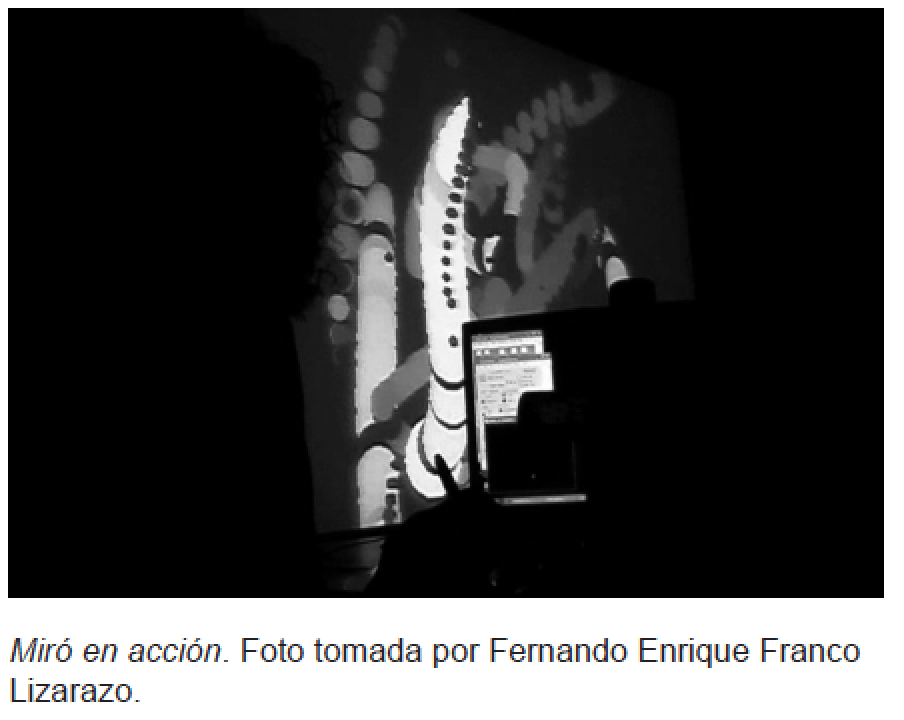

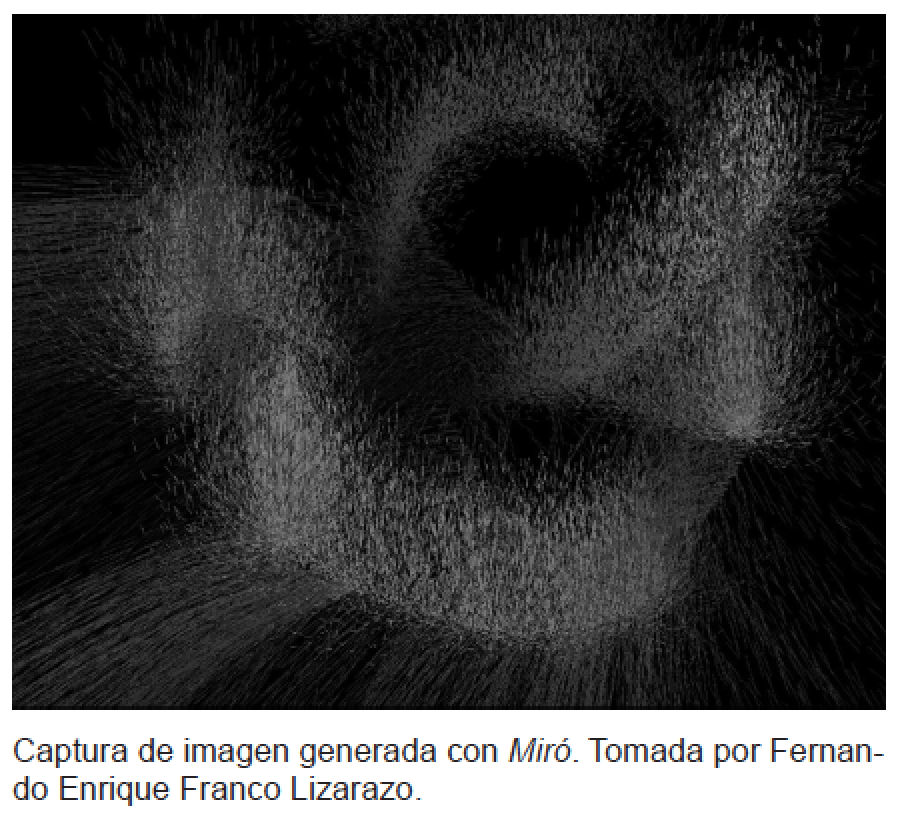

Estas diferentes aproximaciones al gesto se pueden aplicar en sistemas audiovisuales con fines expresivos, tomando en cuenta el tipo de control que se va a usar y los resultados esperados. En Miró (Franco et. al, 2004) el gesto instrumental o de manipulación es muy importante, ya que la acción de dibujar es la metáfora usada para generar imagen y sonido por esta razón, se usaron una tableta gráfica y un lápiz electrónico como dispositivos de control del sistema, lo que permite que los gestos de excitación se vean reflejados en las características del resultado audiovisual. De esta forma se da una retroalimentación sonora, visual y háptica a las acciones del intérprete.

Modos de interación

Así como el gesto, el término interacción también tiene diferentes significados según el contexto. En los proyectos mencionados en este artículo se han considerado importantes las siguientes connotaciones relacionadas con la música hecha con computador (Wanderley, 2001):

a) Manipulación de instrumentos (interacción interprete-instrumento).

b) Manipulación de dispositivos para control de partituras o instrucciones.

c) Manipulación de dispositivos para post- producción.

d) Interacción en el contexto de instalaciones interactivas multimedia.

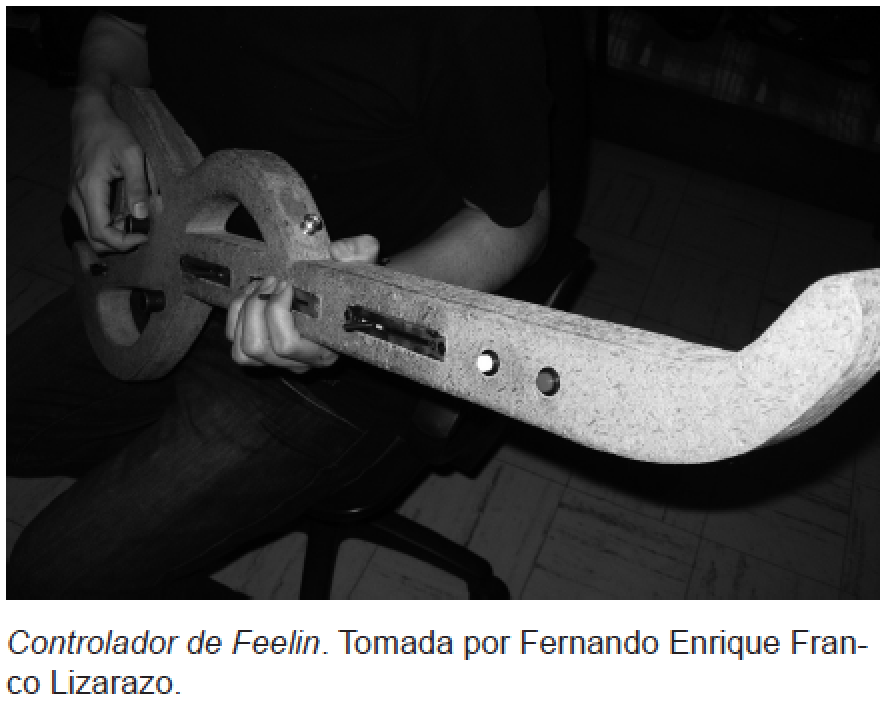

Feelin´(Franco, s.f.) cuenta con un dispositivo de control soportado por un sistema que recibe y analiza acciones en tiempo real y una interface física que combina la apariencia de guitarra y la lectura y transformación de los gestos del intérprete en datos. En este sistema se aplican los tres primeros modos de interacción.

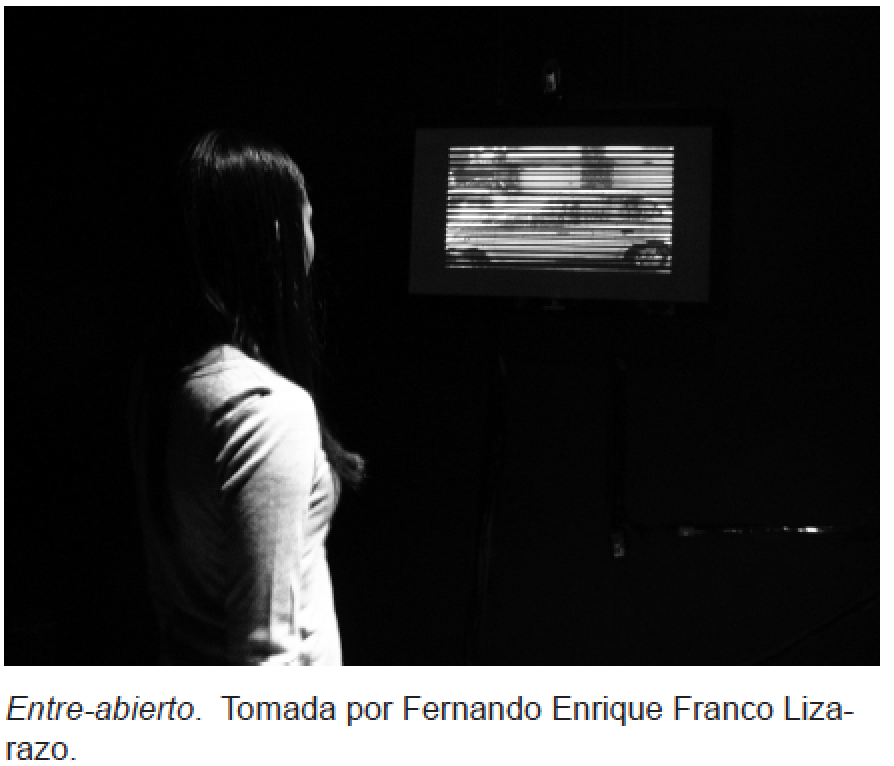

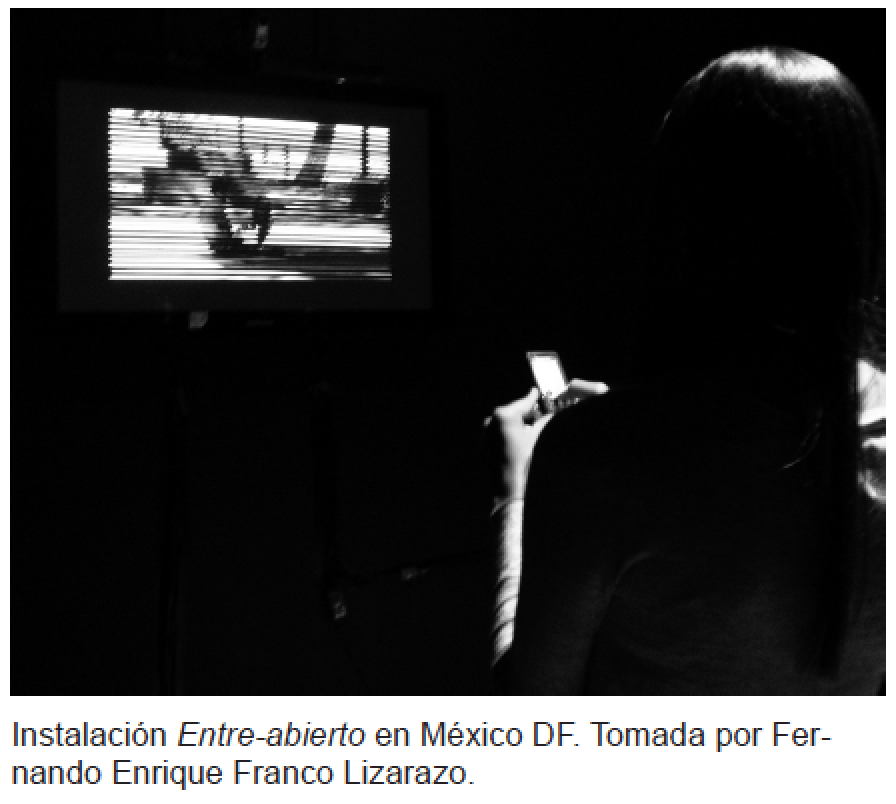

En Miró (Franco et. al, 2004) se usa la manipulación de instrumentos para generar tanto sonido como imagen, ya que se controlan parámetros visuales y sonoros en tiempo real. Asimismo, por medio de paneles de control gráficos se modifican los parámetros capturados a partir de las acciones del intérprete. La instalación interactiva Entre-abierto (Franco, 2010) usa una cámara de video como sensor de movimiento de las personas para modificar las propiedades de la imagen y sonido proyectados.

Controles

Uno de los aspectos más interesantes del desarrollo de entornos interactivos basados en software, es el potencial que ofrecen para encontrar nuevas maneras de conectar o diseñar elementos y estrategias de control en correspondencia con las necesidades del artista o usuario. Es así como se abren posibilidades para artistas o intérpretes con diversas habilidades físicas y motrices, vocabulario gestual, intereses personales y tendencias culturales, para experimentar nuevas formas de expresión o acelerar el proceso de aprendizaje y dominio del funcionamiento de sistemas innovadores. Perry Cook (2000) plantea algunos principios para diseñar y construir controles para interpretación musical basada en software, entre los que se encuentran los siguientes: nuevos algoritmos sugieren nuevos controles, nuevos controles sugieren nuevos algoritmos, instrumentos existentes sugieren nuevos controles, objetos de uso cotidiano sugieren controles divertidos. En Hemogramas (Colectivo PLUG, s.f.) se explora el uso de controles de videojuegos inalámbricos (wiimotes) y sus múltiples parámetros de control para promover la participación del público a distancia, transformando el video y el sonido. En esta pieza se aplica el principio de nuevos controles sugieren nuevos algoritmos.

Según Mulder (1998) algunos tópicos a tener en cuenta para desarrollar superficies de control son expandir el rango de gestos de instrumentos existentes, para explotar gestos o movimientos no convencionales o poco usados, y encontrar métodos específicos para hacer instrumentos musicales lo más adaptables posible. Desde hace varios años han surgido diversos proyectos enfocados en el desarrollo de nuevos controles que aprovechan las tecnologías disponibles y que algunos investigadores llaman controles alternativos y se pueden clasificar de forma general así: controles para tocar que requieren que el intérprete toque una superficie de control física, controles de rango expandido, que requieren contacto de manera limitada, y controles inmersivos, que tienen pocas restricciones de movimiento y se pueden adaptar a las capacidades específicas de cada intérprete.

La variedad de controles disponibles en la actualidad es bastante amplia si se toman en cuenta los basados en MIDI, muy usados en ámbitos musicales, los controles de videojuegos, sensores, actuadores y microcontroladores programables como Wiring (s.f.), Arduino (s.f.) y BasicStamp (Parallax, s.f.) que permiten crear inter- faces personalizadas.

En resumen, algunas características que debe tener un control con fines expresivos son: representación háptica, adaptabilidad a nuevos gestos, alta resolución y precisión, control de múltiples parámetros en tiempo real, capacidad de control continuo y control discreto para algunas tareas.

Retroalimentación visual dinámica

Varios artistas y compositores musicales han experimentado por muchos años con las correspondencias de color/imagen y música/sonido. Por ejemplo, los códigos de color para tonos musicales descritos por el compositor Nikolai Rimsky-Korsakoff en el siglo XIX y el control de iluminación y estimulación olfativa a partir de partituras musicales del compositor Alexander Scriabin. Experiencias multisensoriales pre-grabadas fueron desarrolladas en el cine y se pueden encontrar en propuestas como el Senso-rama de Morton Heling (1960). La obra y técnicas desarrolladas por artistas del siglo XX como Oskar Fischinger, Thomas Wilfred, Norman McLaren y John Withney hicieron importantes aportes en composición audiovisual y las relaciones entre imagen, sonido y control.

Algunos sistemas basados en espectogramas como Metasynth (s.f.) y Yellowtail (Levin, 2000) producen sonidos a partir de imágenes. Adicionalmente, se han desarrollado esquemas de notación para representar la paleta expandida del so- nido y las posibilidades cambiantes de performance o interpretación de música por computador. Curtis Roads (1996) pro- pone cuatro funciones para los nuevos esquemas de notación:

a) Para ayudar al compositor a visualizar un trabajo durante su creación (la notación como un medio expresivo).

b) Para especificar parámetros para síntesis de sonido.

c) Para comunicar instrucciones a los músicos en concierto.

d) Para documentación (partituras para estudio y enseñanza).

Otras posibilidades de expresión surgen al manipular un dispositivo de dibujo como las tabletas y lápices electrónicos. Se aprovecha la temporalidad implícita de los gestos, ligada a un dispositivo de entrada de alta resolución, para capturar los matices de los movimientos del usuario. Si se usa en conjunto con un programa para dibujar o pintar, se puede crear prácticamente cualquier imagen (Levin, 2000) a partir de una diversidad de trazos con gran variedad de características (forma, textura, color, brillo, intensidad, etc). Es así como se pueden crear diversos modelos o prototipos para comunicar visualmente diferentes aspectos del sonido. En algunos proyectos como Miró (Franco et al, 2004), se exploran representaciones alternativas que dan al usuario indicaciones de la variación de parámetros sonoros en el tiempo, mediante retroalimentación visual dinámica. De esta forma la visualización no es solo una representación estática de la interfaz de control, sino un elemento activo de la composición con un valor estético particular.

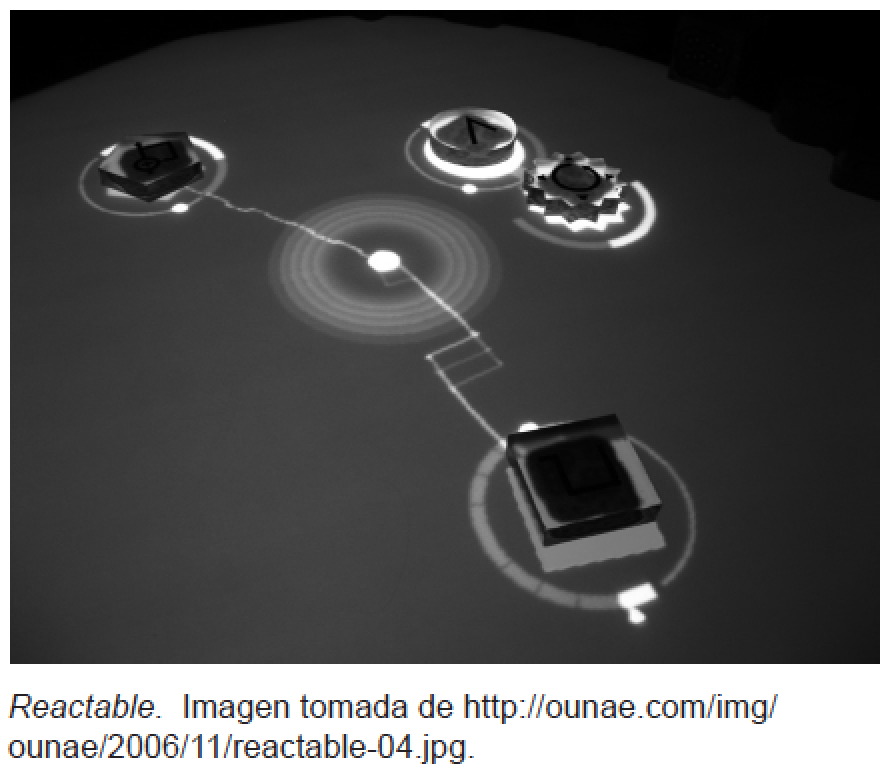

Piezas creadas a partir de imagen abstracta en movimiento, video y animaciones, permiten desarrollar composiciones más complejas y experimentar con las características de la imagen. Técnicas de edición y manipulación de video en vivo (por ejemplo el software usado por los Vjs), el uso de paletas de efectos y animación ligadas a dispositivos de control basados en gestos y sensores, así como sistemas de proyección innovado- res (pantallas de LEDs, video mapping), abren posibilidades para experimentar con nuevas formas de expresión visual. Dispositivos como la Reactable (Jordá, 2003), utilizan elementos visuales dinámicos para facilitar el control de parámetros de sonido.

En resumen, la retroalimentación visual en un sistema audiovisual puede ser más expresiva si se toman en cuenta las siguientes características: uso de imagen dinámica o animada, formas libres o abstractas, editable y transformable, controlada y/o generada a partir de gestos, diversidad de algoritmos de síntesis y control de parámetros en tiempo real.

Aspectos musicales y sonoros

Para lograr expresividad sonora en sistemas basados en software, se pueden usar métodos de síntesis de sonido que permiten modificar parámetros de algoritmos en tiempo real. Existen varios métodos de síntesis (aditiva, sustractiva, modulación de frecuencia, granular, etc.), disponibles gracias a la evolución de la música por computador y la tecnología musical. Mediante controles gestuales se puede crear un rango infinito de timbres y manipular su evolución a lo largo del tiempo. Diversas estrategias de configuración o mapeo (mapping) se pueden aplicar dependiendo del número de variables de control paralelas, las modalidades de control (discreta, continua) y las dimensiones de control. Asimismo, se pueden crear estructuras para organizar eventos sonoros y componer piezas más complejas. Muchos artistas trabajan con conceptos asociados a la teoría musical tradicional como repeticiones, acentos, silencios, duración, dinámica y ritmo. Si además de esto dichas estructuras se pueden editar, el control sobre el resultado aumenta y por ende la complejidad y variedad de la composición.

Otra posibilidad consiste en usar archivos de audio (samples) que se pueden transformar en vivo modificando sus características temporales y tímbricas mediante sistemas comerciales como Ableton Live, MAX/MSP y no comerciales como Pure Data (s.f.), Chuck (s.f.) y Supercollider (s.f.). En la pieza Live Fire (Colectivo PLUG, s.f.) se implementó una máquina de ritmos en Pure Data que permite generar estructuras musicales y disparar archivos de audio de forma dinámica en relación con clips de video. En Miró (Franco et al, 2004) se implementaron varios algoritmos de síntesis de sonido y sus parámetros se pueden relacionar con diferentes parámetros visuales (saturación, color, brillo) y de la interfaz de control (posición en los ejes X y Y, presión).

En resumen, a partir de la experimentación y revisión de diversos sistemas, algunas características que se pueden tomar en cuenta para lograr un sistema sonoro expresivo son: uso de síntesis de sonido en tiempo real, diversas formas de control sobre los parámetros, control y transformación de archivos y secuencias de audio, control gestual, diferentes métodos para grabar, reproducir y modificar secuencias.

Flexibilidad en la configuración de los sistemas

Debido a que no hay un mapeo o asignación objetiva de sonido a imagen o viceversa, la flexibilidad en dicho mapeo es importante para los usuarios a la hora de buscar una retroalimentación audio- visual a partir de una entrada gestual. Wanderley (2001) afirma que cambiando el mapeo usado, el mismo gesto puede llevar a la producción de imágenes y sonidos completamente diferentes. La flexibilidad en un sistema audiovisual se puede lograr teniendo múltiples generadores de gráficas y sonido conectados mediante un mapeo configurable. De esta forma se expande el rango expresivo y de control del sistema.

Siguiendo la experiencia de Wanderley (2001), en Miró (Franco et. al, 2004) se implementó un sistema de mapeo configurable por el usuario. Mediante el uso de módulos, el mapeo puede ser completamente programable siendo limitado sólo por la cantidad de módulos de síntesis y la cantidad de parámetros de entrada. Sin embargo, esta aproximación permite sugerir presets o asignaciones predeterminadas para introducir al usuario novato a las posibilidades de interacción.

Existen sistemas flexibles y modulares en el mercado como Modul8 (s.f.) para componer video en vivo o Ableton Live (s.f.) para componer e improvisar con archivos de audio y estructuras musicales. Sin embargo, los sistemas comerciales presentan algunas limitaciones a la actividad creativa, ya que muchas de sus funciones están predeterminadas. Es importante para los artistas y compositores que trabajan con medios digitales, utilizar sistemas abiertos o ambientes de programación como Pure Data, GEM, VVVV, o Processing, desarrollados para usuarios con poca o ninguna experiencia con lenguajes de programación. Entre más control se tiene de los medios para producir sonido e imagen, se abren mayores posibilidades de experimentación y de resultados más precisos y acordes con la intención del autor.

Participación y colaboración

La idea planteada por Marcel Duchamp acerca de que el espectador completa la obra de arte, se ha retomado de forma frecuente y literal en muchas obras realizadas con medios digitales. Las características propias de la materia digital planteadas por autores como Lev Manovich (2001), como la representación numérica, la modularidad, la automatización, y la variabilidad, hacen que las obras se vuelvan maleables y modificables de diversas maneras, por ejemplo con la participación del público. Las tecnologías de comunicación y de sensores permiten conectar el mundo “físico” y las acciones de las personas con elementos visuales y sonoros propuestos por los artistas. Esta idea de participación que toma fuerza con el arte conceptual, el performance y los happenings, puede enmarcarse dentro de lo que Nicolás Bourriaud (2004) propone como estética o arte relacional. Con el auge de los medios digitales, surge un interés de los artistas por involucrar cada vez más a los espectadores como co-autores de las obras, gracias a la interacción a distancia a través de redes, la transformación de elementos visuales y sonoros con el movimiento del cuerpo, el aporte de contenidos mediante dispositivos móviles, entre otros.

En las instalaciones Entre-abierto (Franco, 2010) y Distancias (Franco et. al, 2010) la interacción y transformación de la proyección sonora y visual, se enmarca dentro de lo que el diseñador italiano Alessandro Valli (s.f.) propone como interacción natural. Valli se refiere al uso de formas de comunicación naturalmente asociadas a los seres humanos como el habla, los gestos y la mirada, eliminando la manipulación de controles y elementos externos a las personas para el manejo de aplicaciones con computadores. En Entre-abierto la transformación del sonido y la imagen dependen de la ubicación y movimientos de los espectadores al desplazarse en el espacio de la instalación y de las imágenes que envían desde sus teléfonos celulares. El espectador debe explorar las posiciones desde las cuales se hace más o menos evidente lo que se oye y se ve. La instalación siempre está activa y en constante cambio. En el performance audiovisual Hemogramas (Colectivo PLUG, s.f.), los espectadores pueden transformar el sonido y proyec- ción de video en algunos pasajes de la pieza mediante controles de videojuegos inalámbricos, haciendo referencia a las formas de interacción y estética de los videojuegos, bastante comunes en nuestra época y que facilitan una participación inmediata del público.

Conclusiones

La experimentación con medios digitales abre nuevas posibilidades de expresión audiovisual gracias a las características propias de lo digital como la programabilidad, la modularidad, la representación numérica y la automatización. Por lo general, la producción de obras artísticas va acompañada del manejo de técnicas y medios de expresión; al desarrollar propuestas con medios digitales es muy útil trabajar con herramientas y sistemas flexibles como ambientes de programación y diseño de hardware especializado que permitan la exploración y resultados acordes con las intenciones del artista. Asimismo, una estrategia que ha tenido buenos resultados, es darle nuevos usos a tecnologías y dispositivos de control y comunicación existentes, en la búsqueda de generar conexiones entre elementos sonoros y visuales. La gestualidad natural de los seres humanos es una fuente importante para conseguir resultados expresivos, lo cual se puede lograr mediante la implementación de controles y sistemas de sensores conectados a parámetros visuales y sonoros.

Los conceptos tratados en este artículo se han puesto en práctica en diversos proyectos y piezas audiovisuales, con un interés especial en seguir promoviendo la participación de los espectadores en la creación y transformación de elementos visuales y sonoros.

Lista de referencias

Ableton. (s.f.). http://www.ableton.com. Recuperado el 8 de abril de 2011.

Arduino. (s.f.) http://www.arduino.cc. Recuperado el 8 de abril de 2011.

Bourriaud, N. (2004). Estética Relacional. Adriana

Hidalgo Editora, Buenos Aires.

Cadoz, C. (1988). Instrumental Gesture and Musical Composition. In Proceedings of the 1988 Interna- tional Computer Music Conference. San Francisco, California.

Choi, I. (1998). Cognitive Engineering of Gestural Primitives for Multi-Modal Interaction in a Virtual Environment. In Proceeding of the IEEE International Conference on Systems, Man and Cybernetics (SMC’98). San Diego, CA , USA.

Chuck. (s.f.). http:// chuck.cs.princeton.edu. Recuperado el 11 de abril de 2011.

C o l e c t i v o P L U G ( s . f . ) . h t t p : / / r i c h i e . i d c . ul.ie/~enrique/plug.htm

Cook, P. (2001). Principles for Designing Computer Music Controllers. In Proceedings of the NIME Workshop. CHI 2001. Seattle, WA, USA.

Cycling74. (s.f.) http://cycling74.com. Recuperado el 8 de abril de 2011.

Franco, E. (2010). Applying Mobile Communication Technologies in Interactive Media Projects. Case study: entre-abierto (half-open) interactive installation. In Proceedings of MEXIHC. Universidad Politécnica de San Luis Potosí, México.

http://richie.idc.ul.ie/~enrique/plug.htm. Recuperado el 8 de abril de 2011.

Franco, E., Aguirre, J. (2010). Distancias: instalación interactiva en el espacio público basada en el uso de dispositivos móviles. Memorias de Sigradi 2010, XIV Congreso de la Sociedad Iberoamericana de Gráfica Digital. Universidad de los Andes. Bogotá, Colombia.

Franco, E., Griffith, N. & Fernstrom, M. (2004). Issues for Designing a Flexible Expressive Audiovisual System for Real-time Performance and Composition. In Proceedings of the 2004 International Conference on New Interfaces for Musical Expression - NIME04, Hamamatsu, Japan.

GEM. (s.f.) http://acg.media.mit.edu/people/golan/aves/.Recuperado el 8 de abril de 2011.

Jordá, S. (2003). Sonigraphical Instruments: From FMOL to the reacTable*. Proceedings of the 2003 Conference on New Interfaces for Musical Expres- sion (NIME-03). Montreal, Canada. http://www. music.mcgill.ca/musictech/nime

Levin, G. (2000). Painterly interfaces for audiovisual performance. Master’s Thesis, Massachusets Institute of Technology, MIT Media Lab, Cambridge.

(s.f.).http://acg.media.mit.edu/people/golan/aves/Audiovisual Environment Suite. Recuperado el 8 de abril de 2011.

Manovich, L. (2001). The language of new media. MIT Press, Cambridge.

MetaSynth. (s.f.). http://www.uisoftware.com/ MetaSynth/index.php Recuperado el 8 de abril de 2011.

Modul8. (s.f.). http://www.garagecube.com/mo-dul8. Recuperado el 8 de abril de 2011.

Mulder, A. (1998). Design of Gestural Constraints Using Virtual Musical Instruments. PhD thesis, School of Kinesiology, Simon Fraser University, Canada.

Parallax. (s.f.). http://www.parallax.com. Recuperado el 8 de abril de 2011.

Processing. (s.f.).http://processing.org. Recuperado el 8 de abril de 2011.

Pure Data. (s.f.). http://puredata.info. Recuperado el 8 de abril de 2011.

Resolume. (s.f.). http://www.resolume.com. Recuperado el 8 de abril de 2011.

Roads, C. (1996). Computer Music Tutorial. MIT Press, Cambridge, Massachusetts.

Supercollider (s.f.). http://www.audiosynth.com/ Recuperado el 11 de abril de 2011.

Valli, A. (s.f.). Notes on Natural Interaction. Recuperado el 8 de abril de 2011. http://www.natura- linteraction.org/images/whitepaper.pdf

VVVV. (s.f.). http://vvvv.org. Recuperado el 8 de abril de 2011.

Wanderley, M. (2001). Performer-Instrument Interaction: Applications to Gestural Control of Sound Synthesis. PHD Thesis, University Paris 6.

Wiring. (s.f.). http://wiring.org.co. Recuperado el 8 de abril de 2011.

Este documento fue tomado de www.revistaelastrolabio.com

- 165 lecturas